Tóm tắt

-

Mặc dù đơn giá cho mỗi đơn vị tính toán (token) của các mô hình AI thế hệ cũ đang giảm mạnh, tổng chi phí thực tế lại không giảm, thậm chí còn tăng.

-

Các công ty ứng dụng AI phải đối mặt với “thế tiến thoái lưỡng nan về định giá” giữa mô hình thuê bao cố định không bền vững và mô hình dựa trên mức sử dụng không hấp dẫn khách hàng, dẫn đến biên lợi nhuận bị thu hẹp.

-

Tương lai của chi phí AI không đồng nhất, mà đang phân hóa với sự trỗi dậy của các mô hình chuyên biệt, mã nguồn mở (như Llama) như một giải pháp thay thế chi phí thấp cho các tác vụ hẹp.

Trong bối cảnh phát triển công nghệ hiện nay, trí tuệ nhân tạo (AI) đã trở thành lực lượng chuyển đổi trong nhiều lĩnh vực kinh tế và xã hội. Một trong những kỳ vọng phổ biến đi kèm với sự tiến bộ của AI là việc chi phí ứng dụng sẽ giảm dần theo thời gian, tương tự như quy luật Moore đã chi phối ngành công nghiệp bán dẫn trong nhiều thập kỷ. Luận điểm này cho rằng khi các mô hình ngôn ngữ lớn (LLM) trở nên hiệu quả hơn, chi phí cho mỗi đơn vị xử lý sẽ giảm, từ đó mở ra khả năng tiếp cận rộng rãi và giảm giá thành dịch vụ.

Tuy nhiên, thực tế triển khai và vận hành các hệ thống AI lại cho thấy một bức tranh phức tạp hơn. Nhiều doanh nghiệp và nhà phát triển ứng dụng AI đang đối mặt với một nghịch lý: trong khi đơn giá cho mỗi đơn vị tính toán (token) có xu hướng giảm đối với các mô hình thế hệ cũ, tổng chi phí vận hành lại không giảm, thậm chí còn tăng lên. Tình trạng này đặt ra một câu hỏi cơ bản: AI đang thực sự trở nên rẻ hơn hay đắt hơn?

Đơn giá Token và mức tiêu thụ tổng thể

Nền tảng của cuộc thảo luận về chi phí AI nằm ở sự tương tác giữa hai biến số: đơn giá của tài nguyên tính toán và tổng lượng tài nguyên được tiêu thụ. Sự sụt giảm của yếu tố thứ nhất đã tạo ra kỳ vọng về một tương lai AI chi phí thấp, nhưng sự bùng nổ của yếu tố thứ hai lại đang định hình một thực tế khác.

Cơ sở cho lập luận “AI đang rẻ hơn” đến từ sự cải thiện hiệu suất trong quá trình suy luận (inference) – tức là quá trình một mô hình AI đã được huấn luyện tạo ra kết quả từ một đầu vào mới. Chi phí này thường được đo bằng “token”, một đơn vị cơ bản của văn bản (có thể là một từ, một phần của từ, hoặc một ký tự).

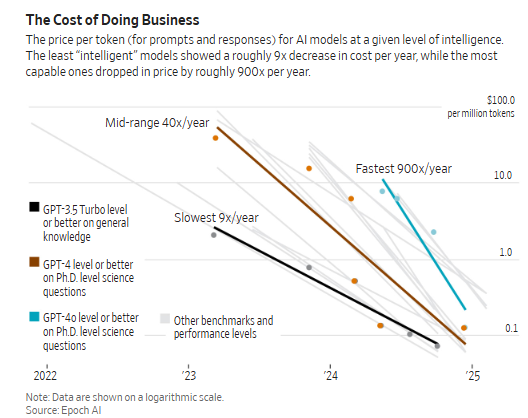

Dữ liệu từ các tổ chức như Epoch AI và các công ty đầu tư mạo hiểm như Andreessen Horowitz (a16z) cho thấy một xu hướng giảm giá rõ rệt. Chi phí cho mỗi triệu token đối với một mô hình có năng lực tương đương đã giảm theo cấp số nhân. Ví dụ, chi phí để vận hành một mô hình ở cấp độ năng lực của GPT-3.5 đã giảm tới 10 lần trong một khoảng thời gian ngắn. Tốc độ giảm giá này, đôi khi được mô tả là giảm “3 lần sau mỗi 6 tháng”, đã củng cố niềm tin rằng chi phí vận hành AI sẽ sớm trở thành một yếu tố không đáng kể.

Sự sụt giảm này là kết quả của nhiều yếu tố: tối ưu hóa phần mềm, cải tiến kiến trúc mô hình, và sự phát triển của phần cứng chuyên dụng (GPU, TPU). Về mặt lý thuyết, một nhà phát triển ứng dụng có thể kỳ vọng rằng, với cùng một khối lượng công việc, chi phí của họ sẽ giảm đáng kể theo thời gian, cho phép họ cải thiện biên lợi nhuận hoặc giảm giá cho người dùng cuối. Tuy nhiên, kỳ vọng này dựa trên một giả định quan trọng: cả nhu cầu của thị trường và bản chất của các tác vụ AI đều không thay đổi.

Giả định về sự ổn định của nhu cầu đã không còn đúng trong thực tế. Thị trường công nghệ, đặc biệt là trong lĩnh vực AI, luôn bị chi phối bởi nhu cầu tiếp cận công nghệ tiên tiến nhất (state-of-the-art – SOTA). Các mô hình thế hệ cũ, dù có giá thành rẻ hơn, nhanh chóng trở nên lỗi thời và không còn hấp dẫn. Hiện tượng này được mô tả như việc “không ai muốn đọc tờ báo của ngày hôm qua”.

Khi một mô hình mới, mạnh mẽ hơn được phát hành (ví dụ, sự chuyển đổi từ GPT-3.5 sang GPT-4, hay sự xuất hiện của Claude 3 Opus), gần như toàn bộ nhu cầu của các nhà phát triển và người dùng cao cấp ngay lập tức dịch chuyển sang mô hình mới. Người tiêu dùng mong đợi các sản phẩm họ sử dụng được tích hợp những khả năng tốt nhất. Do đó, các công ty ứng dụng AI phải chịu áp lực cạnh tranh để liên tục cập nhật, sử dụng các mô hình SOTA nhằm duy trì lợi thế hiệu suất, dù chỉ là một cải tiến nhỏ.

Điều này tạo ra một chu kỳ kinh tế đặc thù. Giá của các mô hình SOTA khi ra mắt thường được định ở một mức cao và tương đối ổn định (ví dụ, khoảng 60 USD/triệu token). Khi GPT-4 ra mắt, nó đắt hơn GPT-3.5 tới 26 lần, nhưng thị trường vẫn chấp nhận mức giá đó để đổi lấy hiệu suất vượt trội. Tương tự, sự ra đời của Claude 3 Opus đã thu hút người dùng dù GPT-4 đã có những đợt giảm giá.

[Còn tiếp]

Bạn có thể đọc thêm nội dung chi tiết của bài này trên trang substack [cần trả phí].